Het klinkt als een plot van Black Mirror : aan studenten wordt gevraagd om overeenkomende objecten te identificeren, maar wanneer een robot een duidelijk fout antwoord geeft, herhalen sommige kinderen wat de bot letterlijk zegt in plaats van hun eigen wijsheid te gebruiken. Maar dit is geen science fiction - een nieuwe studie gepubliceerd in Science Robotics suggereert dat kinderen gemakkelijk bezwijken voor groepsdruk van robots.

Discover's Bill Andrews meldt dat een team van Duitse en Britse onderzoekers 43 kinderen tussen de 7 en 9 jaar hebben gerekruteerd om deel te nemen aan het Asch-experiment, een sociale conformiteitstest die zich voordeed als een visueel examen. Het experiment, dat voor het eerst werd ontwikkeld in de jaren 1950, vraagt de deelnemers om vier lijnen te vergelijken en de twee overeenkomsten in lengte te identificeren. Er is een duidelijk correct antwoord, omdat de lijnen meestal van enorm verschillende lengtes zijn en wanneer de kinderen afzonderlijk werden getest, gaven ze 87 procent van de tijd de juiste reactie.

Zodra robots op het toneel verschenen, daalden de scores echter tot 75 procent.

"Toen de kinderen alleen in de kamer waren, waren ze behoorlijk goed in de taak, maar toen de robots deelnamen en foute antwoorden gaven, volgden ze gewoon de robots", studie co-auteur Tony Belpaeme, een robotica aan de Universiteit van Plymouth in het Verenigd Koninkrijk, vertelt James Vincent van The Verge.

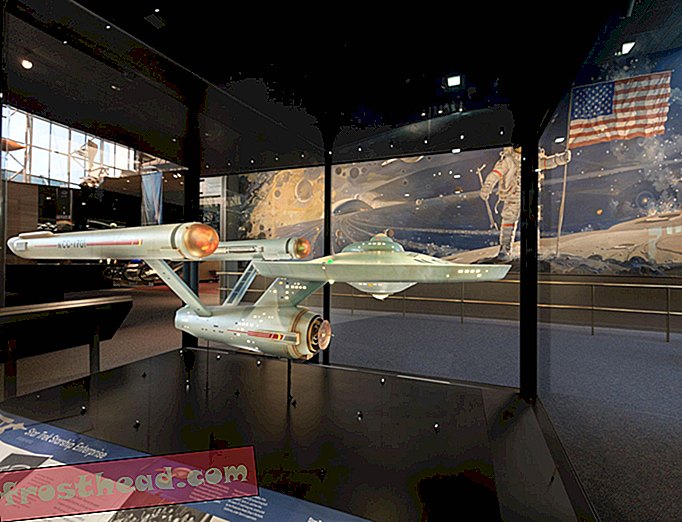

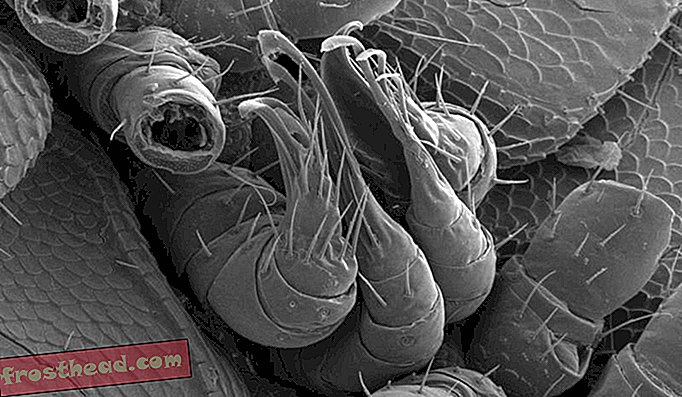

Hier worden de gebruikte robot, de opzet van het experiment en de "vision-test" getoond aan deelnemers getoond (Vollmer et al.)

Hier worden de gebruikte robot, de opzet van het experiment en de "vision-test" getoond aan deelnemers getoond (Vollmer et al.) In de nieuwe testomgeving zat één vrijwilliger tegelijk naast drie humanoïde robots. Hoewel de lijnen waarvoor beoordeling nodig was, sterk te onderscheiden bleven, twijfelden de deelnemers aan het kind en zochten hun robot-tegenhangers om advies. Van de onjuiste antwoorden die de kinderen gaven, kwam 74 procent overeen met die van de robots woord voor woord.

Alan Wagner, een ruimtevaartingenieur aan de Pennsylvania State University die niet betrokken was bij de nieuwe studie, vertelt Carolyn Y. Johnson van The Washington Post dat het onverzoenlijke vertrouwen dat mensen vaak in machines hechten, bekend staat als 'automatisering bias'.

"Mensen zijn geneigd te geloven dat deze machines meer weten dan zij, meer bewust zijn dan zij eigenlijk doen", merkt Wagner op. "Ze doordrenken hen met al deze verbazingwekkende en fantasievolle eigenschappen."

De Verge's Vincent schrijft dat de onderzoekers dezelfde test hebben uitgevoerd op een groep van 60 volwassenen. Anders dan de kinderen, bleven deze oudere deelnemers bij hun antwoorden en weigerden ze in de (onjuiste) voetstappen van de robot te treden.

Het ingetogen uiterlijk van de robots kan het gebrek aan vertrouwen van volwassen deelnemers hebben beïnvloed, legt Belpaeme uit.

"[Ze] hebben niet genoeg aanwezigheid om invloedrijk te zijn, " vertelt hij Vincent. "Ze zijn te klein, te speelgoedachtig."

Deelnemers die aan het einde van het examen werden ondervraagd, verifieerden de theorie van de onderzoekers en verklaarden dat zij ervan uitgingen dat de robots niet goed functioneerden of niet voldoende geavanceerd waren om het juiste antwoord te geven. Het is mogelijk, merkt Belpaeme op, dat als de studie zou worden herhaald met meer autoritair ogende robots, volwassenen net zo vatbaar zouden blijken te zijn als kinderen.

Volgens een persbericht hebben de bevindingen van het team verstrekkende gevolgen voor de toekomst van de robotica-industrie. Naarmate "autonome sociale robots" steeds vaker voorkomen op het gebied van onderwijs en kinderhulp, waarschuwen de onderzoekers dat beschermende maatregelen moeten worden genomen om "het risico voor kinderen tijdens sociale kind-robot-interactie te minimaliseren."