Zoals Memorial Day ons elk jaar herinnert, gaat oorlog niet weg.

Maar het verandert wel. En een van de meest ingrijpende verschuivingen die we de komende jaren zullen zien, is naar een leger dat steeds afhankelijker wordt van robots. Drones krijgen nu de meeste aandacht, maar meer en meer van de innovaties van het ministerie van Defensie zijn andere soorten onbemande machines, van experimentele vliegtuigen tot soldaten op het terrein.

Het is gemakkelijk om de attractie te begrijpen. Het gebruik van robots is mogelijk efficiënter, preciezer en goedkoper dan alleen in oorlogvoering op mensen vertrouwen. En het zou natuurlijk ook minder menselijke slachtoffers betekenen.

Maar deze transformatie brengt een complexe uitdaging met zich mee: kunnen militaire machines worden geprogrammeerd om beslissingen te nemen? Dat leidt tot een plakkerere vraag: kunnen robots moraliteit leren?

Het US Office of Naval Research denkt dat het nu tijd is om daar achter te komen. Eerder deze maand kondigde het een vijfjarige subsidie van $ 7, 5 miljoen aan om onderzoek te financieren aan de universiteiten van Tufts, Brown, Yale en Georgetown en het Rensselaer Polytechnic Institute (RPI) over de vraag of machines ooit goed en fout kunnen kiezen.

De marine wil de situatie vermijden waarin de bestuurderloze auto van Google zich nu bevindt: een technologie die ver voor alle duidelijkheid over de juridische en ethische kwesties die deze met zich meebrengt wordt vrijgegeven. Voordat autonome robots het veld in gaan, wil het leger weten of ze daadwerkelijk kunnen leren het juiste te doen.

Zoals Selmer Bringsjord, hoofd van de afdeling Cognitive Science van RPI, ziet, zou de kunstmatige intelligentie van een robot kunnen worden ontworpen om op twee morele niveaus te functioneren. De eerste zou gebaseerd zijn op een checklist van duidelijke ethische keuzes, zoals "als je een gewonde soldaat tegenkomt, moet je hem of haar helpen." Maar wat als deze actie in strijd is met zijn primaire missie, zoals het leveren van munitie die nodig is voor andere soldaten? Op dat moment zou de robot volgens Bringsjord de mogelijkheid moeten hebben om “dieper moreel te redeneren” om beslissingen te nemen in situaties die zijn programmeurs misschien niet hadden kunnen voorzien.

Onderzoekers zouden unieke algoritmen en computationele mechanismen moeten ontwikkelen die kunnen worden geïntegreerd in de bestaande architectuur van autonome robots, een 'denkproces' waarmee een machine gepland gedrag kan opheffen op basis van zijn vermogen om moreel redeneren toe te passen.

Als dit buitengewoon ambitieus lijkt, is het dat wel. Om te beginnen zullen de onderzoekers de basiselementen van de menselijke moraliteit moeten isoleren - over welke principes zijn we het allemaal eens? - en er vervolgens achter komen hoe ze kunnen worden opgenomen in algoritmen die robots een zekere mate van morele competentie zouden geven.

Dat is geen kleine onderneming. Om die reden is het waarschijnlijk dat machines die niet door mensen worden bestuurd, in de nabije toekomst beperkt zullen blijven tot niet-gevechtsrollen, zoals bewaking, beveiliging, opsporing en redding of medische zorg. Maar het is onvermijdelijk dat militaire planners een antwoord willen op de vraag die dit alles oproept: moeten robots, die op zichzelf handelen, ooit een mens mogen doden?

Als een machine 90 procent zeker weet dat iedereen in een voertuig die hij wil schieten een terrorist is, is dat zeker genoeg? Zou een robot een wapen op een kind kunnen afvuren als het vaststelt dat het de vijand is? Als er iets misgaat en een autonome robot per ongeluk een dorp opblaast, wie is er dan verantwoordelijk? De commandant die de operatie heeft besteld? De persoon die de robot heeft geprogrammeerd? Of niemand?

Als je denkt dat dit nog steeds science fiction is, denk er dan aan dat eerder deze maand experts op onderwerpen van kunstmatige intelligentie tot mensenrechten en internationaal recht tijdens een conferentie van de Verenigde Naties in Genève een rol speelden bij 'moordende robots'. Groepen zoals Human Rights Watch en ambtenaren uit een handvol landen, waaronder Pakistan, Egypte, Cuba en het Vaticaan, riepen op tot een volledig verbod op robots met de autoriteit om te doden. Maar de meeste landen, met name die met de meest geavanceerde robots, zijn niet klaar om zover te gaan.

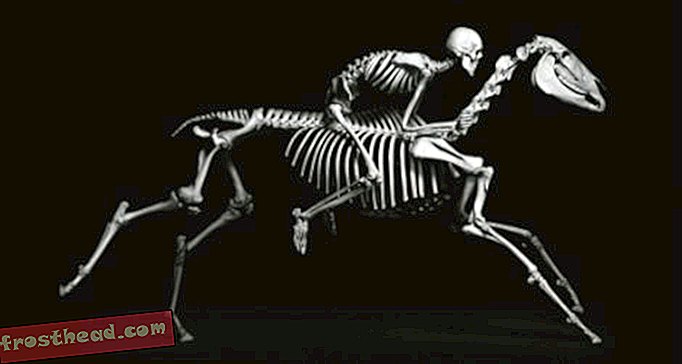

Kijk bijvoorbeeld naar de WildCat, een vierbenige robot die wordt ontwikkeld om met hoge snelheden op alle soorten terrein te rijden.

Voorlopig volgt het Amerikaanse leger een richtlijn van het ministerie van Defensie uit 2012 dat geen enkele machine met de macht om te doden volledig autonoom kan zijn. Een mens moet letterlijk de baas zijn. Maar dat geldt misschien niet voor alle plaatsen: in maart citeerde New Scientist een Russische functionaris die zei dat robotwachters bij vijf ballistische raketteninstallaties doelen kunnen detecteren en vernietigen zonder dat een mens groen licht geeft.

De Foster-Miller Talon, hieronder te zien, is een van de vele machines over de hele wereld die worden ontwikkeld voor gevechten.

Regels van oorlog

Een rapport over de moordenaarrobotconferentie zal in november worden gepresenteerd aan de commissie bepaalde wapens van de VN. Maar het lijkt er niet op dat er binnenkort een verbod komt.

Onder de deelnemers aan de discussie in Genève was Ronald Arkin, een expert op het gebied van kunstmatige intelligentie van Georgia Tech, die al lang een pleitbezorger is voor het geven van machines de mogelijkheid om morele beslissingen te nemen. Hij gelooft dat als robots kunnen leren het internationale recht te volgen, ze zich ethischer zouden gedragen dan mensen in oorlogvoering, omdat ze onfeilbaar consistent zouden zijn. Ze zouden niet kunnen reageren in woede of met paniek of vooroordelen. Dus Arkin verzet zich tegen een verbod, hoewel hij openstaat voor een moratorium op autonome wapens totdat machines de kans krijgen om te zien of ze de oorlogsregels kunnen beheersen.

Een andere AI-wetenschapper, Noel Sharkey, die over Arkin debatteerde in Genève, is van een heel andere geest. Hij vindt niet dat robots ooit de autoriteit moeten krijgen om beslissingen over leven of dood te nemen.

Onlangs vertelde hij Defense One : “Ik denk niet dat ze ooit zullen eindigen met een morele of ethische robot. Daarvoor hebben we morele keuzevrijheid nodig. Daarvoor moeten we anderen begrijpen en weten wat het betekent om te lijden. "

"Een robot kan worden geïnstalleerd met enkele ethische regels, maar dat kan me niet echt schelen", zegt hij.