Iedereen heeft gehoord over de nieuwe ontwikkelingen in kunstmatige intelligentie, en vooral machine learning. Je hebt ook utopische of apocalyptische voorspellingen gehoord over wat die vorderingen betekenen. Ze zijn genomen om ofwel onsterfelijkheid of het einde van de wereld te voorspellen, en er is veel geschreven over beide mogelijkheden. Maar de meest geavanceerde AI's zijn nog lang niet in staat om problemen op te lossen die menselijke vierjarigen met gemak bereiken. Ondanks de indrukwekkende naam bestaat kunstmatige intelligentie grotendeels uit technieken om statistische patronen in grote gegevenssets te detecteren. Menselijk leren heeft veel meer te bieden.

Hoe kunnen we zoveel over de wereld om ons heen weten? We leren enorm veel, zelfs als we kleine kinderen zijn; vierjarigen kennen al planten en dieren en machines; verlangens, overtuigingen en emoties; zelfs dinosaurussen en ruimteschepen.

De wetenschap heeft onze kennis over de wereld uitgebreid tot het onvoorstelbaar grote en het oneindig kleine, tot de rand van het universum en het begin van de tijd. En we gebruiken die kennis om nieuwe classificaties en voorspellingen te maken, nieuwe mogelijkheden voor te stellen en nieuwe dingen in de wereld te laten gebeuren. Maar het enige dat ons over de hele wereld bereikt, is een stroom fotonen die ons netvlies raakt en luchtverstoringen in onze trommelvliezen. Hoe leren we zoveel over de wereld als het bewijs dat we hebben zo beperkt is? En hoe doen we dit allemaal met de paar kilo grijze goo die achter onze ogen zit?

Het beste antwoord tot nu toe is dat onze hersenen berekeningen uitvoeren op de concrete, bijzondere, rommelige gegevens die bij onze zintuigen aankomen, en die berekeningen leveren nauwkeurige weergaven van de wereld op. De voorstellingen lijken gestructureerd, abstract en hiërarchisch te zijn; ze omvatten de perceptie van driedimensionale objecten, de grammatica's die ten grondslag liggen aan taal, en mentale capaciteiten zoals 'theorie van de geest', waardoor we begrijpen wat andere mensen denken. Die representaties stellen ons in staat om een breed scala aan nieuwe voorspellingen te doen en vele nieuwe mogelijkheden op een onderscheidende creatieve menselijke manier te bedenken.

Dit soort leren is niet het enige soort intelligentie, maar het is vooral belangrijk voor mensen. En het is het soort intelligentie dat een specialiteit is van jonge kinderen. Hoewel kinderen dramatisch slecht zijn in planning en besluitvorming, zijn ze de beste leerlingen in het universum. Veel van het proces van het omzetten van gegevens in theorieën gebeurt voordat we vijf zijn.

Sinds Aristoteles en Plato zijn er twee basismanieren om het probleem aan te pakken van hoe we weten wat we weten, en dit zijn nog steeds de belangrijkste benaderingen in machine learning. Aristoteles heeft het probleem van onderaf benaderd: begin met zintuigen - de stroom fotonen en luchttrillingen (of de pixels of geluidsvoorbeelden van een digitale afbeelding of opname) - en kijk of je er patronen uit kunt halen. Deze benadering werd verder gedragen door klassieke associaties als filosofen David Hume en JS Mill en later door gedragspsychologen, zoals Pavlov en BF Skinner. Volgens deze opvatting is de abstractheid en de hiërarchische structuur van representaties iets van een illusie, of op zijn minst een epifenomeen. Al het werk kan worden gedaan door associatie en patroonherkenning, vooral als er voldoende gegevens zijn.

Mogelijke gedachten: 25 manieren om naar AI te kijken

John Brockman uit de wetenschapswereld verzamelt vijfentwintig van de belangrijkste wetenschappelijke geesten, mensen die voor het grootste deel van hun carrière hebben nagedacht over kunstmatige intelligentie, voor een ongeëvenaard rondetafelonderzoek over geest, denken, intelligentie en wat het betekent om mens zijn.

KopenIn de loop van de tijd is er een wip geweest tussen deze bottom-up benadering van het mysterie van leren en Plato's alternatieve, top-down benadering. Misschien halen we abstracte kennis uit concrete gegevens omdat we al veel weten, en vooral omdat we dankzij evolutie al een scala aan abstracte basisconcepten hebben. Net als wetenschappers kunnen we die concepten gebruiken om hypothesen over de wereld te formuleren. In plaats van te proberen patronen uit de onbewerkte gegevens te halen, kunnen we voorspellingen doen over hoe de gegevens eruit moeten zien als die hypothesen kloppen. Samen met Plato namen deze 'rationalistische' filosofen en psychologen als Descartes en Noam Chomsky deze benadering aan.

Hier is een alledaags voorbeeld dat het verschil tussen de twee methoden illustreert: het oplossen van de spam-pest. De gegevens bestaan uit een lange, ongesorteerde lijst met berichten in uw inbox. De realiteit is dat sommige van deze berichten echt zijn en sommige spam. Hoe kunt u de gegevens gebruiken om ze te discrimineren?

Overweeg eerst de bottom-up techniek. U merkt dat de spamberichten meestal bepaalde kenmerken hebben: een lange lijst met geadresseerden, oorsprong in Nigeria, verwijzingen naar miljoenenprijzen of Viagra. Het probleem is dat perfect nuttige berichten mogelijk ook deze functies hebben. Als je genoeg voorbeelden van spam- en niet-spam-e-mails hebt bekeken, zie je misschien niet alleen dat spam-e-mails die functies meestal hebben, maar dat de functies op bepaalde manieren samengaan (Nigeria plus een miljoen dollar spreukenproblemen). In feite kunnen er subtiele correlaties op een hoger niveau zijn die de spamberichten onderscheiden van de nuttige - bijvoorbeeld een bepaald patroon van spelfouten en IP-adressen. Als u die patronen detecteert, kunt u de spam eruit filteren.

De bottom-up machine-learningtechnieken doen precies dit. De leerling krijgt miljoenen voorbeelden, elk met een aantal functies en elk gemarkeerd als spam (of een andere categorie) of niet. De computer kan het patroon van functies extraheren dat de twee onderscheidt, zelfs als het vrij subtiel is.

Hoe zit het met de top-downbenadering? Ik krijg een e-mail van de redacteur van het Journal of Clinical Biology . Het verwijst naar een van mijn artikelen en zegt dat ze graag een artikel van mij willen publiceren. Geen Nigeria, geen Viagra, geen miljoen dollar; de e-mail heeft geen van de functies van spam. Maar door wat ik al weet te gebruiken en op een abstracte manier na te denken over het proces dat spam produceert, kan ik erachter komen dat deze e-mail verdacht is:

1. Ik weet dat spammers proberen geld van mensen te winnen door een beroep te doen op menselijke hebzucht.

2. Ik weet ook dat legitieme 'open access'-tijdschriften hun kosten zijn gaan dekken door auteurs in rekening te brengen in plaats van abonnees, en dat ik niet zoiets doe als klinische biologie.

Zet dat allemaal bij elkaar en ik kan een goede nieuwe hypothese produceren over waar die e-mail vandaan kwam. Het is ontworpen om academici ertoe te bewegen te betalen om een artikel in een neptijdschrift te 'publiceren'. De e-mail was het resultaat van hetzelfde dubieuze proces als de andere spam-e-mails, hoewel het er niet zo uitzag. Ik kan deze conclusie trekken uit slechts één voorbeeld, en ik kan verder gaan met het testen van mijn hypothese, verder dan alles in de e-mail zelf, door de "editor" te googelen.

In computertermen begon ik met een 'generatief model' dat abstracte concepten zoals hebzucht en bedrog omvat en het proces beschrijft dat e-mailzwendel produceert. Daardoor kan ik de klassieke Nigeriaanse e-mailspam herkennen, maar ik kan me ook veel verschillende soorten mogelijke spam voorstellen. Wanneer ik de tijdschrift-e-mail ontvang, kan ik achteruit werken: "Dit lijkt alleen maar het soort e-mail dat uit een spamgeneratieproces zou komen."

De nieuwe opwinding over AI komt omdat AI-onderzoekers recent krachtige en effectieve versies van beide leermethoden hebben geproduceerd. Maar er is niets diep nieuws aan de methoden zelf.

Bottom-up diep leren

In de jaren tachtig bedachten computerwetenschappers een ingenieuze manier om computers patronen in gegevens te laten detecteren: connectionistische of neurale netwerkarchitectuur (het "neurale" deel was en is nog steeds metaforisch). De aanpak viel in de val in de jaren 1990, maar is onlangs nieuw leven ingeblazen met krachtige "deep-learning" methoden zoals DeepMind van Google.

U kunt bijvoorbeeld een programma met veel kennis een aantal internetafbeeldingen geven met het label 'kat', anderen met het label 'huis', enzovoort. Het programma kan de patronen detecteren die de twee sets afbeeldingen onderscheiden en die informatie gebruiken om nieuwe afbeeldingen correct te labelen. Sommige soorten machine learning, onbewaakt leren genoemd, kunnen patronen in gegevens zonder labels detecteren; ze zoeken eenvoudig naar clusters van functies - wat wetenschappers een factoranalyse noemen. In de deep-learning machines worden deze processen op verschillende niveaus herhaald. Sommige programma's kunnen zelfs relevante functies ontdekken uit de onbewerkte gegevens van pixels of geluiden; de computer kan beginnen met het detecteren van de patronen in de onbewerkte afbeelding die overeenkomen met randen en lijnen en vervolgens de patronen in die patronen vinden die overeenkomen met gezichten, enzovoort.

Een andere bottom-uptechniek met een lange geschiedenis is leren van versterking. In de jaren vijftig bouwde BF Skinner, voortbouwend op het werk van John Watson, beroemd geprogrammeerde duiven om uitgebreide acties uit te voeren - zelfs door lucht gelanceerde raketten naar hun doelen te leiden (een verontrustende echo van recente AI) door ze een bepaald schema van beloningen en straffen te geven . Het essentiële idee was dat acties die werden beloond, zouden worden herhaald en acties die werden gestraft niet, totdat het gewenste gedrag was bereikt. Zelfs in de tijd van Skinner kan dit eenvoudige proces, steeds herhaald, leiden tot complex gedrag. Computers zijn ontworpen om keer op keer eenvoudige bewerkingen uit te voeren op een schaal die de menselijke verbeelding overtreft, en computersystemen kunnen op deze manier opmerkelijk complexe vaardigheden leren.

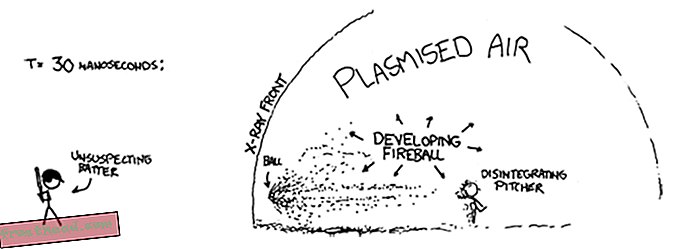

Onderzoekers van DeepMind van Google gebruikten bijvoorbeeld een combinatie van diep leren en versterkend leren om een computer te leren Atari-videogames te spelen. De computer wist niets over hoe de spellen werkten. Het begon met willekeurig handelen en kreeg alleen informatie over hoe het scherm er op elk moment uitzag en hoe goed het had gescoord. Diep leren hielp de functies op het scherm te interpreteren en versterkend leren beloonde het systeem voor hogere scores. De computer is heel goed geworden in het spelen van verschillende spellen, maar het is ook volledig gebombardeerd op anderen die mensen net zo gemakkelijk onder de knie hadden.

Een vergelijkbare combinatie van diep leren en versterkend leren heeft het succes mogelijk gemaakt van DeepMind's AlphaZero, een programma dat menselijke spelers zowel bij schaken als bij Go wist te verslaan, uitgerust met alleen een basiskennis van de spelregels en een aantal planningscapaciteiten. AlphaZero heeft nog een interessante functie: het werkt door honderden miljoenen spellen tegen zichzelf te spelen. Terwijl het dit doet, snoeit het fouten die tot verliezen hebben geleid, en het herhaalt en werkt strategieën uit die hebben geleid tot overwinningen. Dergelijke systemen, en andere waarbij technieken worden gebruikt die generatieve vijandige netwerken worden genoemd, genereren zowel gegevens als observaties.

Wanneer je de rekenkracht hebt om die technieken toe te passen op zeer grote gegevenssets of miljoenen e-mailberichten, Instagram-afbeeldingen of spraakopnames, kun je problemen oplossen die eerder heel moeilijk leken. Dat is de bron van veel opwinding in de informatica. Maar het is de moeite waard eraan te denken dat die problemen - zoals het erkennen dat een afbeelding een kat is of een gesproken woord Siri is - voor een menselijke peuter triviaal zijn. Een van de meest interessante ontdekkingen in de informatica is dat problemen die voor ons gemakkelijk zijn (zoals het identificeren van katten) moeilijk zijn voor computers - veel moeilijker dan schaken of spelen. Computers hebben miljoenen voorbeelden nodig om objecten te categoriseren die we met slechts enkele kunnen categoriseren. Deze bottom-up systemen kunnen generaliseren naar nieuwe voorbeelden; ze kunnen een nieuwe afbeelding als een kat tamelijk nauwkeurig over het algemeen labelen. Maar ze doen dit op een manier die heel anders is dan hoe mensen generaliseren. Sommige afbeeldingen die vrijwel identiek zijn aan een kattenafbeelding, worden door ons helemaal niet als katten geïdentificeerd. Anderen die eruit zien als een willekeurige vervaging zullen dat zijn.

Top-Down Bayesiaanse modellen

De top-downbenadering speelde een grote rol in de vroege AI en ook in de jaren 2000 kende het een opleving, in de vorm van probabilistische, of Bayesiaanse, generatieve modellen.

De vroege pogingen om deze aanpak te gebruiken stuitten op twee soorten problemen. Ten eerste kunnen de meeste bewijspatronen in principe worden verklaard door veel verschillende hypothesen: het is mogelijk dat mijn e-mailbericht in het dagboek echt is, het lijkt gewoon niet waarschijnlijk. Ten tweede, waar komen de concepten die de generatieve modellen gebruiken in de eerste plaats vandaan? Plato en Chomsky zeiden dat je met hen bent geboren. Maar hoe kunnen we verklaren hoe we de nieuwste wetenschapsconcepten leren? Of hoe zelfs jonge kinderen begrijpen van dinosaurussen en raketschepen?

Bayesiaanse modellen combineren generatieve modellen en hypothesetesten met waarschijnlijkheidstheorie, en ze pakken deze twee problemen aan. Met een Bayesiaans model kunt u berekenen hoe waarschijnlijk het is dat een bepaalde hypothese waar is, gezien de gegevens. En door kleine maar systematische aanpassingen te maken aan de modellen die we al hebben, en ze te toetsen aan de gegevens, kunnen we soms nieuwe concepten en modellen maken van oude. Maar deze voordelen worden gecompenseerd door andere problemen. De Bayesiaanse technieken kunnen u helpen kiezen welke van twee hypotheses waarschijnlijker is, maar er zijn bijna altijd een enorm aantal mogelijke hypothesen, en geen enkel systeem kan ze allemaal efficiënt overwegen. Hoe beslis je welke hypothesen het waard zijn om te testen?

Brenden Lake op NYU en collega's hebben dit soort top-downmethoden gebruikt om een ander probleem op te lossen dat gemakkelijk is voor mensen, maar uiterst moeilijk voor computers: onbekende handgeschreven tekens herkennen. Kijk naar een personage op een Japanse rol. Zelfs als je het nog nooit eerder hebt gezien, kun je waarschijnlijk zien of het lijkt op of verschilt van een personage op een andere Japanse rol. Je kunt het waarschijnlijk tekenen en zelfs een nep Japans personage ontwerpen op basis van degene die je ziet - een die er heel anders uitziet dan een Koreaans of Russisch personage.

De bottom-up methode voor het herkennen van handgeschreven tekens is om de computer duizenden voorbeelden van elk te geven en de meest opvallende kenmerken te laten verwijderen. In plaats daarvan, Lake et al. gaf het programma een algemeen model van hoe je een personage tekent: een lijn gaat naar rechts of links; nadat je er een hebt voltooid, begin je aan een andere; enzovoorts. Toen het programma een bepaald karakter zag, kon het de reeks slagen afleiden die daar waarschijnlijk het gevolg van waren - net zoals ik concludeerde dat het spamproces tot mijn dubieuze e-mail leidde. Vervolgens kon het beoordelen of een nieuw karakter waarschijnlijk het gevolg zou zijn van die reeks of van een andere, en het zou een vergelijkbare reeks slagen zelf kunnen produceren. Het programma werkte veel beter dan een diepgaand leerprogramma dat op precies dezelfde gegevens werd toegepast, en het weerspiegelde nauw de prestaties van mensen.

Deze twee benaderingen van machine learning hebben complementaire sterke en zwakke punten. In de bottom-up benadering heeft het programma in het begin niet veel kennis nodig, maar het heeft veel gegevens nodig en kan slechts op een beperkte manier generaliseren. In de top-downbenadering kan het programma van slechts enkele voorbeelden leren en veel bredere en meer gevarieerde generalisaties maken, maar u moet er in het begin veel meer in inbouwen. Een aantal onderzoekers probeert momenteel de twee benaderingen te combineren, met behulp van diepgaand leren om Bayesiaanse inferentie te implementeren.

Het recente succes van AI is deels het gevolg van uitbreidingen van die oude ideeën. Maar het heeft meer te maken met het feit dat we dankzij internet veel meer gegevens hebben, en dankzij de wet van Moore hebben we veel meer rekenkracht om op die gegevens toe te passen. Bovendien is een niet gewaardeerd feit dat de gegevens die we hebben al zijn gesorteerd en verwerkt door mensen. De kattenfoto's die op internet zijn geplaatst, zijn canonieke kattenfoto's - foto's die mensen al als 'goede' foto's hebben gekozen. Google Translate werkt omdat het gebruikmaakt van miljoenen menselijke vertalingen en deze generaliseert naar een nieuw stuk tekst, in plaats van de zinnen zelf goed te begrijpen.

Maar het echt opmerkelijke aan menselijke kinderen is dat ze op de een of andere manier de beste eigenschappen van elke benadering combineren en dan veel verder gaan. In de afgelopen vijftien jaar hebben ontwikkelingsdeskundigen de manier onderzocht waarop kinderen structuur leren van gegevens. Vierjarigen kunnen leren door slechts een of twee voorbeelden van gegevens te nemen, zoals een top-downsysteem, en te generaliseren naar zeer verschillende concepten. Maar ze kunnen ook nieuwe concepten en modellen leren van de gegevens zelf, zoals een bottom-up systeem.

In ons laboratorium geven we bijvoorbeeld jonge kinderen een 'blicket-detector' - een nieuwe machine om uit te zoeken, een machine die ze nog nooit eerder hebben gezien. Het is een doos die oplicht en muziek speelt wanneer je bepaalde objecten erop zet, maar andere niet. We geven kinderen slechts een of twee voorbeelden van hoe de machine werkt en laten zien dat, laten we zeggen, twee rode blokken het doen, terwijl een groen-gele combinatie dat niet doet. Zelfs achttien maanden oude mensen vinden onmiddellijk het algemene principe dat de twee objecten hetzelfde moeten zijn om het te laten werken, en ze generaliseren dat principe naar nieuwe voorbeelden: ze kiezen bijvoorbeeld twee objecten met dezelfde vorm om te maken het machinewerk. In andere experimenten hebben we laten zien dat kinderen er zelfs achter kunnen komen dat sommige verborgen onzichtbare eigenschappen de machine doen werken, of dat de machine werkt volgens een abstract logisch principe.

Je kunt dit ook laten zien in het dagelijkse leren van kinderen. Jonge kinderen leren snel abstracte intuïtieve theorieën over biologie, natuurkunde en psychologie, net zoals volwassen wetenschappers dat doen, zelfs met relatief weinig gegevens.

De opmerkelijke prestaties van machine learning van de recente AI-systemen, zowel bottom-up als top-down, vinden plaats in een nauwe en goed gedefinieerde ruimte van hypothesen en concepten - een precieze set speelstukken en bewegingen, een vooraf bepaalde set afbeeldingen . Kinderen en wetenschappers veranderen daarentegen soms hun concepten op radicale manieren, door paradigmaverschuivingen uit te voeren in plaats van de concepten die ze al hebben gewoon aan te passen.

Vierjarigen kunnen katten onmiddellijk herkennen en woorden begrijpen, maar ze kunnen ook creatieve en verrassende nieuwe conclusies trekken die veel verder gaan dan hun ervaring. Mijn eigen kleinzoon heeft onlangs bijvoorbeeld uitgelegd dat als een volwassene weer kind wil worden, hij moet proberen geen gezonde groenten te eten, omdat gezonde groenten een kind tot een volwassene laten groeien. Dit soort hypothese, een plausibele die geen enkele volwassene ooit zou kunnen vermaken, is kenmerkend voor jonge kinderen. Mijn collega's en ik hebben zelfs systematisch aangetoond dat kleuters beter zijn in het bedenken van onwaarschijnlijke hypothesen dan oudere kinderen en volwassenen. We hebben bijna geen idee hoe dit soort creatief leren en innovatie mogelijk is.

Als we echter kijken naar wat kinderen doen, kunnen programmeurs nuttige tips krijgen over aanwijzingen voor computerleren. Twee kenmerken van het leren van kinderen zijn bijzonder opvallend. Kinderen zijn actieve leerlingen; ze nemen niet alleen passief gegevens op, zoals AI's. Net zoals wetenschappers experimenteren, zijn kinderen intrinsiek gemotiveerd om informatie uit de wereld om hen heen te extraheren door hun eindeloze spel en verkenning. Recente studies tonen aan dat deze verkenning systematischer is dan het lijkt en goed is aangepast om overtuigend bewijs te vinden om hypothesevorming en theoriekeuze te ondersteunen. Nieuwsgierigheid inbouwen in machines en hen in staat stellen om actief met de wereld te communiceren, kan een weg zijn naar realistischer en breder leren.

Ten tweede zijn kinderen, in tegenstelling tot bestaande KI's, sociale en culturele leerlingen. Mensen leren niet op zichzelf, maar maken gebruik van de opgebouwde wijsheid van vorige generaties. Recente studies tonen aan dat zelfs kleuters leren door imitatie en door te luisteren naar de getuigenis van anderen. Maar ze gehoorzamen niet alleen passief hun leraren. In plaats daarvan nemen ze informatie van anderen op een opmerkelijk subtiele en gevoelige manier op, maken complexe conclusies over waar de informatie vandaan komt en hoe betrouwbaar deze is en integreren systematisch hun eigen ervaringen met wat ze horen.

"Kunstmatige intelligentie" en "machine learning" klinken eng. En in sommige opzichten zijn ze. Deze systemen worden bijvoorbeeld gebruikt om wapens te besturen en daar moeten we echt bang voor zijn. Toch kan natuurlijke domheid veel meer schade aanrichten dan kunstmatige intelligentie; wij mensen zullen veel slimmer moeten zijn dan we in het verleden zijn geweest om de nieuwe technologieën goed te reguleren. Maar er is niet veel basis voor de apocalyptische of de utopische visie van KI's die mensen vervangen. Totdat we de fundamentele paradox van leren hebben opgelost, zullen de beste kunstmatige intelligenties niet kunnen concurreren met de gemiddelde menselijke vierjarige.

Uit de komende collectie MOGELIJKE MINDS: 25 manieren van kijken naar AI, bewerkt door John Brockman. Gepubliceerd in overleg met Penguin Press, een lid van Penguin Random House LLC. Copyright © 2019 John Brockman.