Wat is eerlijk?

Het lijkt een simpele vraag, maar het is er een zonder eenvoudige antwoorden. Dat is met name het geval in de mysterieuze wereld van kunstmatige intelligentie (AI), waar het idee van slimme, emotieloze machines die beslissingen nemen die wonderbaarlijk vrij zijn van vooringenomenheid snel vervaagt.

Misschien kwam de meest openbare geur van die perceptie met een ProPublica-onderzoek uit 2016 dat concludeerde dat de gegevens die een AI-systeem aansturen dat door rechters wordt gebruikt om te bepalen of een veroordeelde crimineel waarschijnlijk meer misdaden pleegt, bevooroordeeld bleken tegen minderheden. Northpointe, het bedrijf dat het algoritme creëerde, bekend als COMPAS, betwistte de interpretatie van ProPublica van de resultaten, maar de botsing heeft zowel discussie als analyse aangewakkerd over hoeveel zelfs de slimste machines moeten worden vertrouwd.

"Het is een heel actueel onderwerp - hoe kun je algoritmen eerlijk en betrouwbaar maken", zegt Daniel Neill. "Het is een belangrijke kwestie."

Neill bevindt zich nu midden in die discussie. Een computerwetenschapper aan Carnegie Mellon University, hij en een andere onderzoeker, Will Gorr, ontwikkelden enkele jaren geleden een misdaadvoorspellende softwaretool met de naam CrimeScan. Hun oorspronkelijke concept was dat gewelddadige misdaad in sommige opzichten als een overdraagbare ziekte is, en dat het de neiging heeft om uit te breken in geografische clusters. Ze kwamen ook tot de overtuiging dat mindere misdaden een voorbode kunnen zijn van meer gewelddadige misdrijven, dus bouwden ze een algoritme met behulp van een breed scala aan "leidende indicator" -gegevens, inclusief rapporten van misdaden, zoals eenvoudige aanvallen, vandalisme en wanordelijk gedrag, en 911 roept over dingen zoals schoten of een persoon gezien met een wapen. Het programma omvat ook seizoens- en dag van de week trends, plus korte en lange termijn percentages van ernstige geweldsmisdrijven.

Het idee is om vonken te volgen voordat er brand uitbreekt. "We kijken naar meer kleine misdaden", zegt Neill. “Eenvoudige aanvallen kunnen verharden tot zware aanvallen. Of misschien heb je een escalerend patroon van geweld tussen twee bendes. '

Voorspellen wanneer en waar

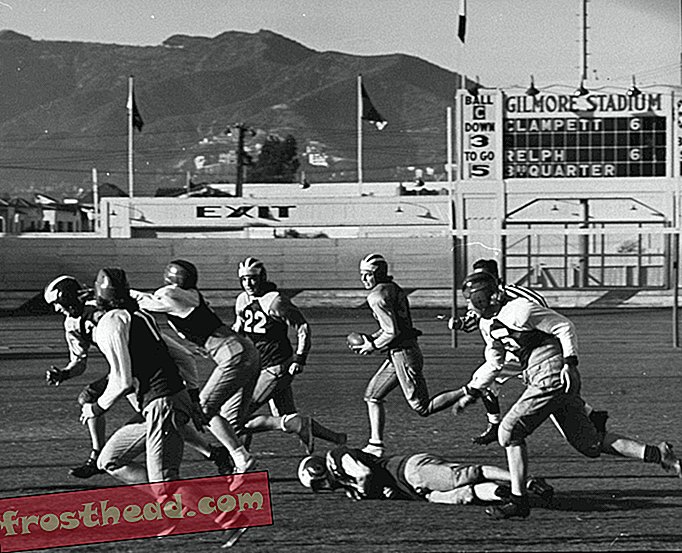

CrimeScan is niet de eerste software die is ontworpen voor wat bekend staat als predictive policing. Een programma genaamd PredPol is acht jaar geleden opgezet door UCLA-wetenschappers in samenwerking met de politie van Los Angeles, met als doel na te gaan hoe wetenschappelijke analyse van misdaadgegevens patronen van crimineel gedrag kan helpen herkennen. Nu gebruikt door meer dan 60 politieafdelingen in het hele land, identificeert PredPol gebieden in een buurt waar zich in een bepaalde periode vaker ernstige misdrijven zullen voordoen.

Het bedrijf beweert dat zijn onderzoek heeft aangetoond dat de software twee keer zo nauwkeurig is als menselijke analisten als het gaat om het voorspellen waar misdaden zullen gebeuren. Geen onafhankelijk onderzoek heeft deze resultaten echter bevestigd.

Zowel PredPol als CrimeScan beperken hun projecties tot waar misdaden kunnen voorkomen, en vermijden het nemen van de volgende stap van het voorspellen wie ze zou kunnen plegen - een controversiële aanpak die de stad Chicago heeft opgebouwd rond een "Strategische onderwerpenlijst" van mensen die het meest waarschijnlijk worden betrokken in toekomstige schietpartijen, hetzij als schutter of als slachtoffer.

De American Civil Liberties Union [ACLU], het Brennan Center for Justice en verschillende burgerrechtenorganisaties hebben allemaal vragen gesteld over het risico dat bias in de software wordt ingebakken. Historische gegevens van politiepraktijken, beweren critici, kunnen een feedbacklus creëren waardoor algoritmen beslissingen nemen die zowel attitudes weerspiegelen als de attitudes versterken over welke buurten “slecht” en welke “goed” zijn. Daarom is AI voornamelijk gebaseerd op arrestatiegegevens een hogere risico op vooringenomenheid - het weerspiegelt meer politiebesluiten, in tegenstelling tot daadwerkelijk gerapporteerde misdaden. CrimeScan bijvoorbeeld, probeert geen misdaden te voorspellen die, zoals Neill het zegt, "je alleen zult vinden als je ze zoekt."

"Ik kan niet zeggen dat we vrij zijn van vooringenomenheid, " zegt Neill, "maar het is zeker meer gereduceerd dan als we zouden proberen het drugbezit te voorspellen."

Dan is er de andere kant van de feedbacklus. Als een voorspellend hulpmiddel de verwachtingen van misdaden in een bepaalde buurt oproept, zal de politie die daar patrouille agressiever zijn dan aanhoudingen?

"Er is een reëel gevaar, met elke vorm van datagedreven politiewerk, om te vergeten dat er mensen aan beide kanten van de vergelijking zijn", merkt Andrew Ferguson op, een professor in de rechten aan de Universiteit van het District of Columbia en auteur van de boek, The Rise of Big Data Policing: Surveillance, Race, and the Future of Law Enforcement. “Officieren moeten deze ideeën kunnen vertalen die suggereren dat verschillende buurten verschillende dreigingsscores hebben. En als je je richt op de cijfers in plaats van op de mens voor je, verandert je relatie ermee. ”

In de zwarte doos

De realiteit is dat kunstmatige intelligentie nu een rol speelt - zij het vaak op de achtergrond - bij veel beslissingen die van invloed zijn op het dagelijks leven - van het helpen van bedrijven bij het kiezen van wie ze inhuren tot het instellen van kredietscores tot het evalueren van leraren. Het is niet verrassend dat dat de publieke controle van hoe machine learning-algoritmen zijn gemaakt, welke onbedoelde gevolgen ze hebben, en waarom ze over het algemeen niet veel worden herzien, heeft geïntensiveerd.

Om te beginnen is veel van de software eigen, dus er is weinig transparantie achter hoe de algoritmen werken. En naarmate machine learning steeds geavanceerder wordt, wordt het steeds moeilijker voor zelfs de ingenieurs die een AI-systeem hebben gemaakt om de gemaakte keuzes uit te leggen. Die ondoorzichtige besluitvorming, met weinig verantwoordelijkheid, is een gevolg van wat bekend staat als 'black box'-algoritmen.

"Het publiek krijgt nooit de kans om het gebruik van dergelijke systemen te controleren of te debatteren", zegt Meredith Whittaker, mede-oprichter van het AI Now Institute, een onderzoeksorganisatie aan de New York University die zich richt op de impact van AI op de samenleving. "En de gegevens en logica die de voorspellingen bepalen zijn vaak onbekend, zelfs voor degenen die ze gebruiken, laat staan voor de mensen wier leven wordt beïnvloed."

In een rapport van afgelopen najaar ging AI Now zover dat het aanbeveelt dat geen enkele openbare instantie die verantwoordelijk is voor zaken als strafrecht, gezondheidszorg, welzijn en onderwijs black box AI-systemen zou moeten gebruiken. Volgens AI Now worden juridische en ethische kwesties zelden in overweging genomen wanneer de software wordt gemaakt.

"Net zoals je een rechter niet zou vertrouwen om een diep neuraal netwerk op te bouwen, moeten we stoppen met aan te nemen dat een ingenieursdiploma voldoende is om complexe beslissingen te nemen op domeinen zoals het strafrecht", zegt Whittaker.

Een andere organisatie, het Center for Democracy & Technology, heeft een tool voor 'digitale beslissingen' gegenereerd om ingenieurs en computerwetenschappers te helpen bij het maken van algoritmen die eerlijke en onpartijdige resultaten opleveren. De tool stelt veel vragen die bedoeld zijn om hen hun aannames te laten wegen en onvoorziene rimpeleffecten te identificeren.

"We wilden mensen een concreet startpunt geven om na te denken over zaken als hoe representatief hun gegevens zijn, welke groepen mensen kunnen worden weggelaten en of de output van hun model onbedoelde negatieve gevolgen zal hebben", zegt Natasha Duarte, die toezicht houdt op het project.

Wie is verantwoordelijk?

Hoewel er een push is geweest om ontwikkelaars meer bewust te maken van de mogelijke gevolgen van hun algoritmen, wijzen anderen erop dat openbare instanties en bedrijven die afhankelijk zijn van AI ook verantwoording moeten afleggen.

“De nadruk ligt er op dat ontwerpers een systeem begrijpen. Maar het gaat ook over de mensen die het systeem beheren en implementeren ”, zegt Jason Schultz, een professor in de rechten aan de New York University die met het AI Now Institute werkt op juridische en beleidskwesties. "Daar komt het rubber op de weg in verantwoording af. Een overheidsinstantie die AI gebruikt, heeft de meeste verantwoordelijkheid en ze moeten het ook begrijpen. Als je de technologie niet begrijpt, zou je hem niet moeten kunnen gebruiken."

Daartoe promoot AI Now het gebruik van "algoritmische effectbeoordelingen", waarvoor openbare instanties de systemen die zij gebruiken zouden moeten vrijgeven en externe onderzoekers in staat zouden stellen deze te analyseren op mogelijke problemen. Als het gaat om politiediensten, vinden sommige juridische experts het ook belangrijk dat ze duidelijk aangeven hoe ze technologie gebruiken en bereid zijn die te delen met de lokale gemeenschap.

"Als deze systemen zijn ontworpen vanuit het oogpunt van verantwoordelijkheid, billijkheid en een eerlijk proces, moet de persoon die het systeem implementeert begrijpen dat ze een verantwoordelijkheid hebben", zegt Schultz. “En wanneer we ontwerpen hoe we deze gaan implementeren, is een van de eerste vragen: 'Waar gaat dit in het politiehandboek over?' Als je dit niet ergens in het politiehandboek zult krijgen, laten we een stapje terug doen, mensen. '

Andrew Ferguson ziet een behoefte aan wat hij een 'surveillance-top' noemt.

"Ten minste eenmaal per jaar moet er een verantwoordingsmoment zijn voor politietechnologie in elk lokaal rechtsgebied", zegt hij. “De politiechef, de burgemeester of misschien het hoofd van de gemeenteraad zou de gemeenschap moeten uitleggen waar ze belastinggeld voor gebruiken in termen van bewaking en technologie, waarom ze denken dat het een goed gebruik van het geld is, wat ze doen het om het te controleren en de gegevens te beschermen, wat zijn de implicaties voor de privacy. En de gemeenschap zou daar zijn om vragen te stellen. "

Daniel Neill, de maker van CrimeScan, zegt dat hij geen bezwaar zou hebben tegen het idee van regelmatige audits van AI-resultaten, hoewel hij bedenkingen heeft voordat een algoritme voldoende in de praktijk wordt getest. Hij werkt momenteel samen met het Pittsburgh Bureau of Police aan een CrimeScan-proces, en in eerste instantie was er een uitdaging met "het verkrijgen van de juiste patrouille-intensiteit voor de voorspelde hotspots."

Het is een leerproces geweest, zegt hij, om CrimeScan aan te passen zodat politieagenten op straatniveau het nuttig vinden. "We moeten laten zien dat we niet alleen criminaliteit kunnen voorspellen, maar ook dat we deze daadwerkelijk kunnen voorkomen, " merkt Neill op. "Als je het gereedschap gewoon over de muur gooit en er het beste van hoopt, werkt het nooit zo goed."

Hij erkent ook het risico van teveel uitstellen naar een algoritme.

"Een hulpmiddel kan politieagenten helpen goede beslissingen te nemen", zegt hij. “Ik geloof niet dat machines beslissingen moeten nemen. Ze moeten worden gebruikt voor beslissingsondersteuning. "

Neill voegt eraan toe: "Ik begrijp wel dat dat in de praktijk niet altijd gebeurt."