![]()

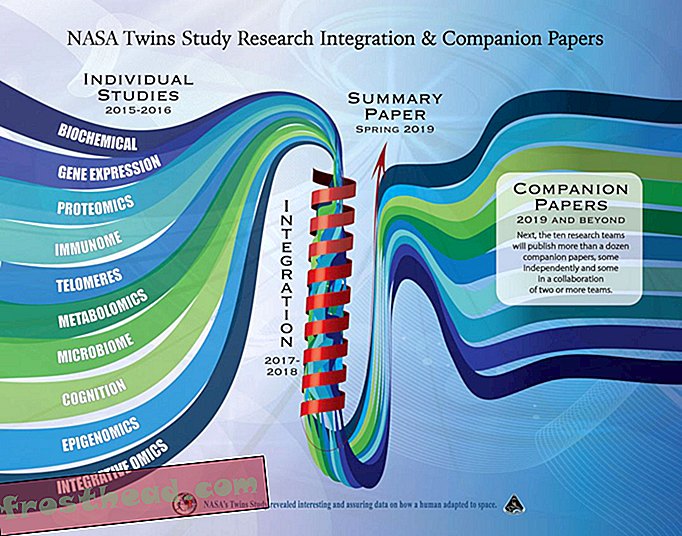

Patroonherkenning van een vlindervleugel. Afbeelding afkomstig van Li Li

Hier in Washington hebben we gehoord dat u 'vooraf plannen' noemt, maar we zijn er nog niet klaar voor. Een beetje te futuristisch.

Toch kunnen we niet anders dan bewonderen van verre mensen die proberen te voorspellen wat er over meer dan een maand zou kunnen gebeuren. Dus ik was enkele weken geleden onder de indruk toen de grote denkers van IBM zich vijf jaar later de wereld verbeeldden en identificeerden wat volgens hen vijf innovatiegebieden zijn die de grootste impact op ons dagelijks leven zullen hebben.

Ze doen dit nu al een paar jaar, maar deze keer volgden de wisky whizzzes een thema - de vijf menselijke zintuigen. Niet dat ze zeggen dat we in 2018 allemaal in staat zullen zijn om beter te zien, horen en ruiken, maar eerder dat machines zullen - dat door snel evoluerende sensorische en cognitieve technologieën te gebruiken, computers hun transformatie van het ophalen van gegevens en van motoren tot denkinstrumenten.

Zie je een patroon?

Laten we vandaag met visie omgaan. Het is een logische sprong om aan te nemen dat IBM mogelijk verwijst naar Google's Project Glass. Het lijdt geen twijfel dat het de rol van een bril opnieuw heeft gedefinieerd, van een nerdy accessoire die ons helpt beter te zien tot een combinatie van smartphone / gegevensduikapparaat dat we ooit op ons gezicht zullen dragen.

Maar dat is niet waar de IBMers het over hebben. Ze zijn gericht op machine vision, met name patroonherkenning, waardoor computers door herhaalde blootstelling aan afbeeldingen dingen kunnen identificeren.

Het blijkt dat Google toevallig betrokken was bij een van de opmerkelijkste experimenten met patroonherkenning van vorig jaar, een project waarin een netwerk van 1.000 computers met 16.000 processoren, na onderzoek van 10 miljoen afbeeldingen van YouTube-video's, zichzelf kon leren wat een kat zag eruit.

Wat dit vooral indrukwekkend maakte, is dat de computers dit konden doen zonder menselijke begeleiding over wat ze moesten zoeken. Al het leren gebeurde via de machines die samen werkten om te beslissen welke kenmerken van katten hun aandacht verdienden en welke patronen ertoe deden.

En dat is het model voor hoe machines visie leren. Hier is hoe John Smith, een senior manager in Intelligent Information Management van IBM, het uitlegt:

“Laten we zeggen dat we een computer wilden leren hoe een strand eruit ziet. We zouden beginnen met de computer veel voorbeelden van strandtaferelen te laten zien. De computer zou die foto's in verschillende functies veranderen, zoals kleurverdelingen, textuurpatronen, randinformatie of bewegingsinformatie in het geval van video. Dan zou de computer beginnen te leren strandgezichten te onderscheiden van andere scènes op basis van deze verschillende functies. Het zou bijvoorbeeld leren dat voor een strandgezicht bepaalde kleurverdelingen doorgaans worden gevonden, vergeleken met een stadsgezicht. ”

Hoe slim is slim?

Goed voor hen. Maar zie het onder ogen, het identificeren van een strand is voor de meesten van ons mensen vrij eenvoudig. Kunnen we ons laten meeslepen over hoeveel denkmachines voor ons kunnen doen?

Gary Marcus, een professor psychologie aan de Universiteit van New York, vindt van wel. Onlangs schreef hij op de website van The New Yorker, maar concludeert dat hoewel er veel vooruitgang is geboekt in wat bekend staat als 'deep learning', machines nog een lange weg te gaan hebben voordat ze als echt intelligent moeten worden beschouwd.

“Realistisch gezien is diep leren slechts een deel van de grotere uitdaging van het bouwen van intelligente machines. Zulke technieken missen manieren om causale relaties weer te geven (zoals tussen ziekten en hun symptomen), en staan waarschijnlijk voor uitdagingen bij het verwerven van abstracte ideeën zoals 'broer of zus' of 'identiek aan'. Ze hebben geen voor de hand liggende manieren om logische gevolgtrekkingen uit te voeren, en ze zijn ook nog ver verwijderd van het integreren van abstracte kennis, zoals informatie over wat objecten zijn, waarvoor ze zijn en hoe ze doorgaans worden gebruikt. "

De mensen bij IBM zullen ongetwijfeld zoveel erkennen. Machine learning komt in stappen, niet in sprongen.

Maar ze geloven dat binnen vijf jaar diep leren voldoende stappen heeft gezet om bijvoorbeeld computers een veel grotere rol te gaan spelen in de medische diagnose, dat ze eigenlijk beter kunnen worden dan artsen als het gaat om het opsporen van tumoren, bloedstolsels of ziek weefsel in MRI's, röntgenfoto's of CT-scans.

En dat kan een groot verschil maken in ons leven.

Zien is geloven

Hier zijn meer manieren waarop machine vision invloed heeft op ons leven:

- Je beste arm naar voren brengen: technologie ontwikkeld aan de Universiteit van Pittsburgh maakt gebruik van patroonherkenning om dwarslaesies in staat te stellen een robotarm met hun hersenen te besturen.

- Je mond zegt ja, maar je hersenen zeggen nee: onderzoekers van Stanford ontdekten dat het gebruik van patroonherkenningsalgoritmen op MRI-scans van hersenen hen kon helpen bepalen of iemand daadwerkelijk pijn in de onderrug had of dat ze het deden alsof.

- Wanneer je moedervlekken klaar zijn voor hun close-ups: vorig jaar lanceerde een Roemeense startup met de naam SkinVision een iPhone-app waarmee mensen een foto kunnen maken van moedervlekken op hun huid en vervolgens de herkenningssoftware van SkinVision eventuele onregelmatigheden kan identificeren en het risiconiveau kan aangeven - zonder biedt een actuele diagnose. De volgende stap is om het mogelijk te maken dat mensen afbeeldingen van hun huid rechtstreeks naar hun dermatoloog sturen.

- Heb ik een deal voor u: nu in ontwikkeling is een marketingtechnologie genaamd Facedeals. Het werkt als volgt: zodra een camera bij de ingang van een winkel u herkent, ontvangt u aangepaste winkelaanbiedingen op uw smartphone. En ja, je moet je eerst aanmelden.

- Ik zou die zegel overal kennen: een geautomatiseerd foto-ID-systeem dat patroonherkenning gebruikt, helpt Britse wetenschappers om grijze zeehonden te volgen, die unieke markeringen op hun jassen hebben.

Videobonus: hoewel we het hebben over kunstmatige intelligentie, is hier een robotzwerm die Beethoven speelt, complimenten van wetenschappers van Georgia Tech. Ik wed dat je dat vandaag niet had verwacht.

Meer van Smithsonian.com

Een meer menselijk kunstmatig brein

Hoe technologie terrorisme bestrijdt